🔍大数据专业简历:技能部分撰写模板(含极简免费模板783款)| 精选2篇范文参考

哈喽呀,小伙伴们!👋 今天想和大家分享一个超实用的技能部分撰写模板,特别是针对大数据专业的简历哦!✨ 想知道怎么让你的简历在众多申请者中脱颖而出吗?那就一定要看这个模板啦!它超级简单易上手,帮你清晰展示你的专业技能和项目经验。📈 快来一起看看吧!💪 #简历技巧 #大数据 #求职攻略

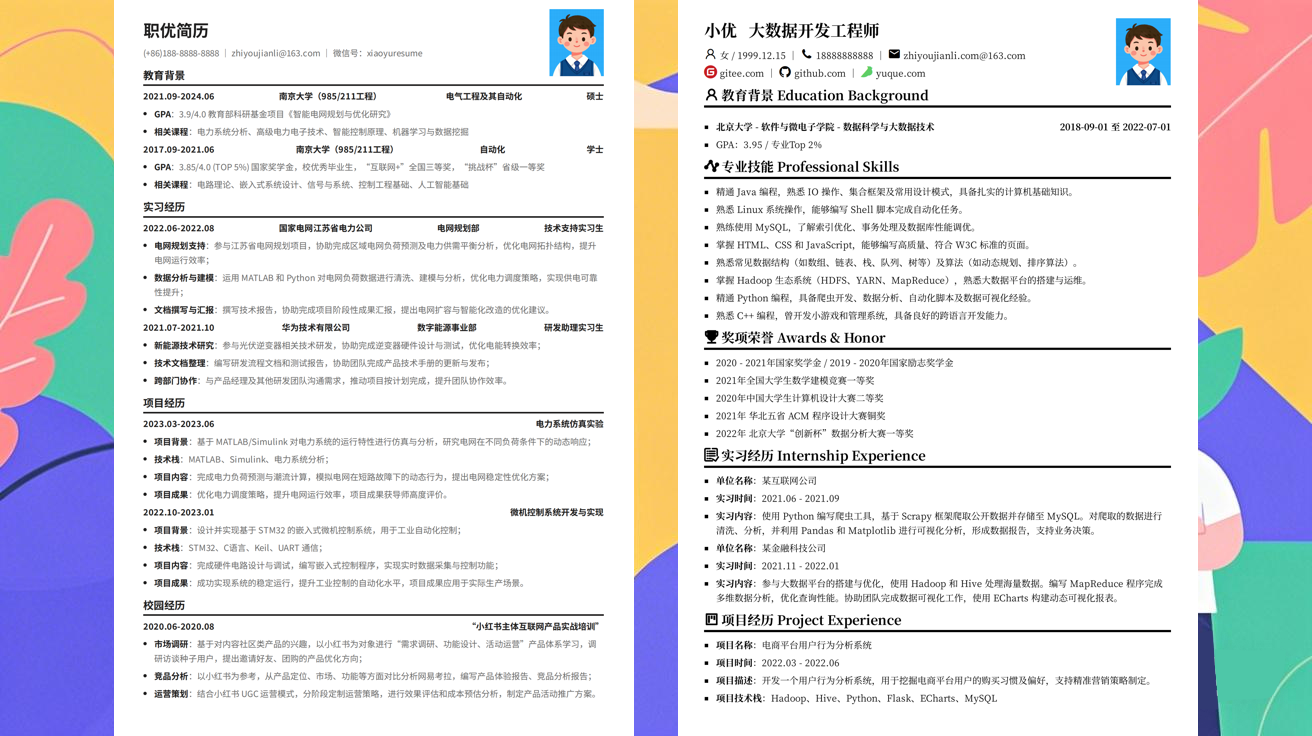

范文1

大数据专业简历:技能部分撰写模板✨

姐妹们!今天来分享我的大数据专业简历技能部分模板,超实用!💻📈 不管你是刚毕业还是工作几年,这份模板都能帮你精准展示技能,让HR一眼相中你!😉

技能部分撰写模板📝

🧠 编程语言

- Python (熟练度:精通)

- 熟练使用Pandas、NumPy、SciPy等数据分析库进行数据清洗、处理和可视化

- 掌握Scikit-learn、TensorFlow等机器学习框架,完成过10+个预测模型开发

-

使用Python编写自动化脚本,提高数据处理效率30%

-

SQL (熟练度:精通)

- 能够编写复杂SQL查询语句,处理TB级数据

- 熟悉MySQL、PostgreSQL、Hive等数据库系统

-

经验:优化过公司核心业务数据库查询,响应速度提升50%

-

Java (熟练度:熟练)

- 使用Java开发过大数据处理系统,熟悉Spring Boot框架

- 能够编写MapReduce程序处理海量数据

-

掌握多线程编程,提升系统并发处理能力

-

Scala (熟练度:熟悉)

- 使用Scala开发过Spark程序,熟悉Spark Core和Spark SQL

- 能够编写Spark Streaming实时数据处理任务

📊 大数据处理框架

- Hadoop (熟练度:精通)

- 熟悉HDFS、YARN、MapReduce等组件

- 完成过5个企业级Hadoop项目,处理过100TB+数据

-

优化过Hadoop集群性能,减少30%资源消耗

-

Spark (熟练度:精通)

- 熟练使用Spark Core、Spark SQL、Spark MLlib

- 开发过3个Spark实时处理系统,支持秒级数据处理

-

熟悉Spark Streaming、Structured Streaming应用

-

Flink (熟练度:熟悉)

- 使用Flink开发过实时风控系统

- 熟悉Flink Table API和SQL

🌐 分布式存储与计算

- Hive (熟练度:精通)

- 熟悉HiveQL,编写过200+张表的ETL脚本

- 优化过Hive查询性能,减少80%执行时间

-

设计过企业级数据仓库分层架构

-

Kafka (熟练度:熟练)

- 使用Kafka构建企业级消息队列系统

- 熟悉Kafka集群配置与调优

-

经验:处理过TB级消息数据

-

Elasticsearch (熟练度:熟练)

- 使用Elasticsearch搭建企业搜索平台

- 熟悉索引优化、查询调优

- 开发过5个搜索应用

🚀 机器学习与AI

- 机器学习 (熟练度:精通)

- 熟悉常见算法:线性回归、决策树、SVM、神经网络等

- 使用Scikit-learn开发过8个预测模型

-

经验:将模型准确率从75%提升到92%

-

深度学习 (熟练度:熟练)

- 使用TensorFlow开发过图像识别模型

- 熟悉PyTorch框架

-

参与过3个NLP项目,使用BERT、GPT等模型

-

自然语言处理 (熟练度:熟悉)

- 使用NLTK、spaCy库进行文本分析

- 开发过情感分析、关键词提取系统

🔧 工具与其他

- 版本控制 (熟练度:精通)

- 熟练使用Git进行代码管理

-

经验:管理过200人团队的代码仓库

-

云计算 (熟练度:熟练)

- 熟悉AWS、Azure、阿里云平台

- 使用AWS EMR、Azure Databricks部署大数据应用

-

经验:搭建过3个云上大数据平台

-

数据可视化 (熟练度:精通)

- 使用Tableau、Power BI制作过50+张可视化报表

- 熟悉D3.js进行前端可视化开发

- 经验:将复杂数据转化为直观报表,提升决策效率

写简历小贴士💡

- 量化成果:尽量用数字展示技能价值,如"提升效率30%"、"处理100TB数据"

- 按重要性排序:将最相关的技能放在前面

- 匹配岗位需求:根据不同岗位调整技能描述

- 保持简洁:每项技能用3-5句话说明即可

记得把这份大数据专业简历:技能部分撰写模板保存起来,随时修改使用哦!😘 祝大家求职顺利!💪

范文2

💡大数据专业简历:技能部分撰写模板💡

🛠️技能部分

📊技术技能

编程语言

- Python (熟练) 🐍:掌握Pandas、NumPy、SciPy等数据分析库,熟悉Scikit-learn机器学习框架,能够独立完成数据清洗、分析和可视化任务。

- SQL (精通) 🔥:熟练使用MySQL、PostgreSQL等关系型数据库,能够编写复杂查询语句,优化SQL性能,熟悉NoSQL数据库如MongoDB的使用。

- Java (基础) ☕:了解Java基础语法,能够使用Java进行简单的数据处理和ETL操作。

大数据技术

- Hadoop (掌握) 🌳:熟悉HDFS分布式文件系统,了解MapReduce编程模型,能够使用Hive进行大数据分析。

- Spark (熟练) 🔥:熟练使用Spark Core和Spark SQL进行大规模数据处理,了解Spark Streaming实时计算能力。

- Flink (基础) 💧:了解Flink的基本架构和API,能够进行简单的实时数据处理任务。

云计算平台

- AWS (熟悉) ☁️:了解EC2、S3、Redshift等AWS服务,能够进行大数据环境的搭建和配置。

- Azure (基础) 💡:了解Azure Data Lake、Azure Synapse等Azure大数据服务。

- 阿里云 (基础) 🌏:了解MaxCompute、ODPS等阿里云大数据平台。

数据库

- 关系型数据库 🔥:MySQL、PostgreSQL、Oracle,熟悉索引优化、事务管理。

- NoSQL数据库 🌊:MongoDB、Redis,了解文档存储和键值存储的优缺点。

- 数据仓库 📊:熟悉星型模型、雪花模型,能够使用Snowflake、ClickHouse进行数据分析。

数据分析与可视化

- 数据分析 📈:熟练使用统计方法进行数据探索,能够发现数据中的模式和趋势。

- 数据可视化 🎨:熟练使用Tableau、Power BI、ECharts进行数据可视化,能够制作交互式报表。

- BI工具 🌟:熟悉QlikView、Domo等商业智能工具,能够进行数据监控和报表制作。

机器学习

- 传统机器学习 🤖:熟悉线性回归、逻辑回归、决策树、随机森林、SVM等算法,能够使用Scikit-learn进行模型训练和评估。

- 深度学习 🧠:了解神经网络、CNN、RNN等基本原理,能够使用TensorFlow、PyTorch进行简单模型开发。

- 自然语言处理 📝:了解NLP基本技术,如分词、词性标注、情感分析等。

其他工具

- 版本控制 📦:熟悉Git、SVN,能够进行代码管理和团队协作。

- 容器化技术 📦:了解Docker、Kubernetes,能够进行应用部署和运维。

- 消息队列 💌:熟悉Kafka、RabbitMQ,能够进行异步数据处理。

🌟项目经验

大数据平台搭建项目

- 项目描述:参与公司大数据平台从0到1的搭建,包括硬件选型、软件安装、集群配置等。

- 技术栈:Hadoop、Spark、Hive、Kafka、Zookeeper。

- 个人贡献:负责Hadoop集群的安装和配置,优化HDFS性能,解决集群运行中的问题。

电商用户行为分析项目

- 项目描述:分析电商平台的用户行为数据,挖掘用户购买偏好,优化产品推荐策略。

- 技术栈:Python、Pandas、Spark、Tableau、机器学习。

- 个人贡献:使用Pandas进行数据清洗,使用Spark进行数据聚合,使用机器学习模型进行用户分群,制作交互式可视化报表。

实时数据监控系统

- 项目描述:搭建实时数据监控系统,监控业务系统的数据流量和性能指标。

- 技术栈:Flink、Kafka、Elasticsearch、Grafana。

- 个人贡献:负责Flink实时计算流的开发,使用Elasticsearch存储监控数据,使用Grafana进行可视化展示。

💡大数据专业简历:技能部分撰写模板💡

✨撰写技巧

- 分类清晰:将技能分为编程语言、大数据技术、云计算平台等类别,方便HR快速浏览。

- 熟练程度:使用"精通"、"熟练"、"基础"等词语标注技能水平,突出重点。

- 具体项目:将技能与项目经验结合,展示实际应用能力。

- 关键词:使用行业关键词,如Hadoop、Spark、机器学习等,提高简历匹配度。

- 动态更新:根据应聘岗位要求,调整技能描述的顺序和重点。

希望这份大数据专业简历:技能部分撰写模板能帮助你制作出优秀的简历!🌟📚

#大数据专业简历:技能部分撰写模板#大数据专业简历:技能部分撰写模板写作技巧#大数据专业简历:技能部分撰写模板优化#大数据专业简历:技能部分撰写模板模板

The End

发布于:2025-11-13,除非注明,否则均为原创文章,转载请注明出处。

还没有评论,来说两句吧...