💼大数据运维工程师职业规划简历撰写技巧与模板(含极简免费模板163款)| 精选1篇范文参考

Hey小伙伴们!👋 想成为大数据运维工程师?简历可是敲门砖哦!✨ 今天就来分享超实用的简历撰写技巧和模板,助你轻松拿Offer!😉 不管你是小白还是进阶选手,这些干货都能帮你优化简历,突出优势!💪 快来一起学习吧!📚 #大数据运维 #简历技巧 #求职必备

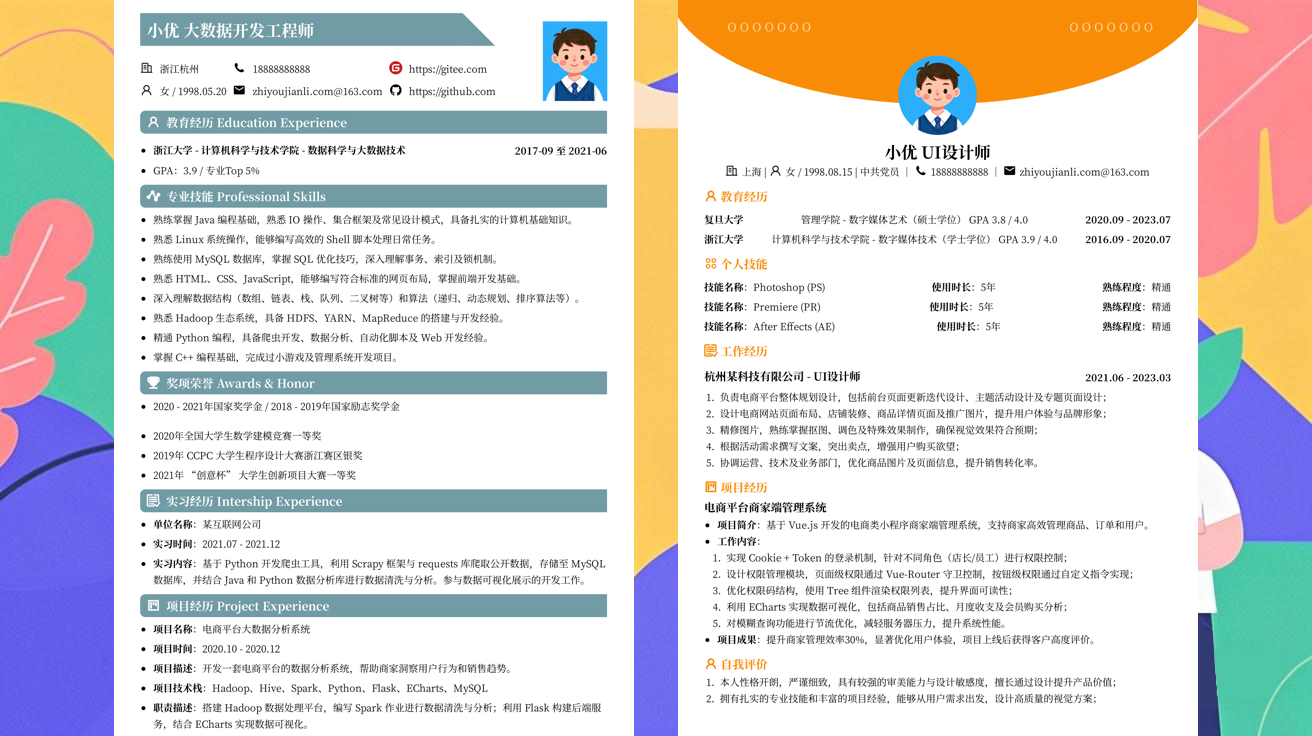

范文1

大数据运维工程师职业规划简历撰写技巧与模板💼✨

姐妹们!今天来聊聊大数据运维工程师职业规划简历撰写技巧与模板!👩💻 作为一枚大数据运维工程师,简历可是咱们的门面担当!写好简历才能敲开心仪公司的大门哦~🚪💖

🔍 简历投递前的准备

在开始写简历之前,咱们得先做好这些准备:

- 明确职业规划:想好自己未来想从事哪方面的大数据运维工作,比如Hadoop运维、Spark运维、云平台运维等。这样简历内容才能更有针对性。🎯

- 梳理项目经验:回顾自己参与过的项目,把项目中的亮点和成果记录下来。比如项目规模、使用的技术栈、解决的问题等。📝

- 掌握关键词:大数据运维工程师常用的关键词有:Hadoop、Spark、Hive、Kafka、Zookeeper、Flink、云平台(AWS/Azure/阿里云)、监控工具(Prometheus/Zabbix)等。把这些关键词自然地融入简历中。🔑

💡 简历撰写技巧

📝 内容结构

一份完整的大数据运维工程师简历通常包含以下几个部分:

- 个人信息:姓名、联系方式、邮箱、GitHub/博客地址等。👤

- 求职意向:明确写明自己想应聘的职位,比如“大数据运维工程师”。🎯

- 专业技能:列出自己掌握的技术栈,按熟练程度排序。🔧

- 项目经验:这是简历的重头戏!详细描述自己参与过的项目,突出自己的贡献和成果。🚀

- 工作经历:如果有过相关工作经验,可以写在这里。按时间倒序排列。📅

- 教育背景:列出自己的教育经历,包括学校、专业、学历等。🎓

- 荣誉奖项:如果获得过相关奖项,可以写在这里。🏆

🌟 技能描述技巧

在描述技能时,不要只写技术名称,还要加上自己的熟练程度和实际应用场景。比如:

- 精通Hadoop生态,包括HDFS、YARN、MapReduce等,曾负责搭建并维护过100TB级别的Hadoop集群。🌳

- 熟练使用Kafka进行数据实时传输,曾优化过Kafka的吞吐量,使数据传输效率提升了50%。📈

📊 项目经验撰写技巧

在描述项目经验时,要使用STAR法则(Situation、Task、Action、Result):

- Situation:项目背景,比如公司业务需求、项目目标等。📈

- Task:你在项目中的任务,比如负责哪些模块、解决什么问题等。📋

- Action:你采取了哪些行动,使用了哪些技术,如何解决难题等。🛠️

- Result:项目的最终成果,比如效率提升、成本降低等。🏆

比如:

项目名称:某电商平台大数据平台搭建

项目描述:

- 背景:公司需要搭建一个大数据平台,用于处理和分析海量用户数据。

- 任务:负责Hadoop集群的搭建和运维,以及数据监控系统的开发。

- 行动:

- 使用Kubernetes进行集群部署,提高了资源利用率。

- 开发了基于Prometheus的数据监控系统,实现了实时监控和告警。

- 成果:

- 集群稳定性提升至99.9%,故障恢复时间缩短了50%。

- 数据监控系统的上线,使问题发现时间减少了70%。🚀

📄 简历模板

以下是一个简单的大数据运维工程师简历模板,姐妹们可以根据自己的实际情况进行修改:🌈

大数据运维工程师简历

个人信息

求职意向

大数据运维工程师

专业技能

- 精通:Hadoop、Spark、Hive、Kafka、Zookeeper、Flink

- 熟悉:云平台(AWS/Azure/阿里云)、监控工具(Prometheus/Zabbix)、Shell脚本

- 了解:Docker、Kubernetes、Jenkins

项目经验

项目名称:某电商平台大数据平台搭建

- 背景:公司需要搭建一个大数据平台,用于处理和分析海量用户数据。

- 任务:负责Hadoop集群的搭建和运维,以及数据监控系统的开发。

- 行动:

- 使用Kubernetes进行集群部署,提高了资源利用率。

- 开发了基于Prometheus的数据监控系统,实现了实时监控和告警。

- 成果:

- 集群稳定性提升至99.9%,故障恢复时间缩短了50%。

- 数据监控系统的上线,使问题发现时间减少了70%。🚀

项目名称:某金融公司实时数据处理系统

- 背景:公司需要实时处理金融交易数据,用于风险控制和精准营销。

- 任务:负责Kafka集群的搭建和运维,以及数据清洗流程的开发。

- 行动:

- 优化了Kafka的配置,使数据传输效率提升了50%。

- 开发了基于Spark的数据清洗流程,提高了数据质量。

- 成果:

- 数据传输延迟从500ms降低到100ms。

- 数据质量问题减少了80%。📈

工作经历

公司名称:XXX科技有限公司

- 职位:大数据运维工程师

- 时间:2020.01 - 2022.12

- 工作内容:

- 负责公司Hadoop集群的日常运维,包括扩容、升级、故障处理等。

- 开发了基于Zabbix的集群监控系统,实现了全面监控和告警。

- 参与了公司大数据平台的架构设计,提出了多项优化建议。

教育背景

- 学校:XXX大学

- 专业:计算机科学与技术

- 学历:本科

- 时间:2016.09 - 2020.06

荣誉奖项

- 2019年:XXX大学优秀毕业生

- 2020年:XXX公司年度优秀员工

🎯 总结

写简历是一个不断优化的过程,姐妹们可以根据每次投递的反馈进行调整。记住,简历是咱们的敲门砖,一定要用心写哦!💪希望这篇大数据运维工程师职业规划简历撰写技巧与模板能帮到大家!祝大家都能找到心仪的工作!🎉💖

发布于:2025-11-12,除非注明,否则均为原创文章,转载请注明出处。

还没有评论,来说两句吧...