📈Python爬虫工程师简历模板(含极简免费模板805款)| 精选2篇范文参考

宝子们!还在为爬虫简历写得干巴巴没亮点发愁吗?🤯 投了N份都石沉大海?别慌!今天挖到一份超实用的Python爬虫工程师简历模板,简直是求职救星✨

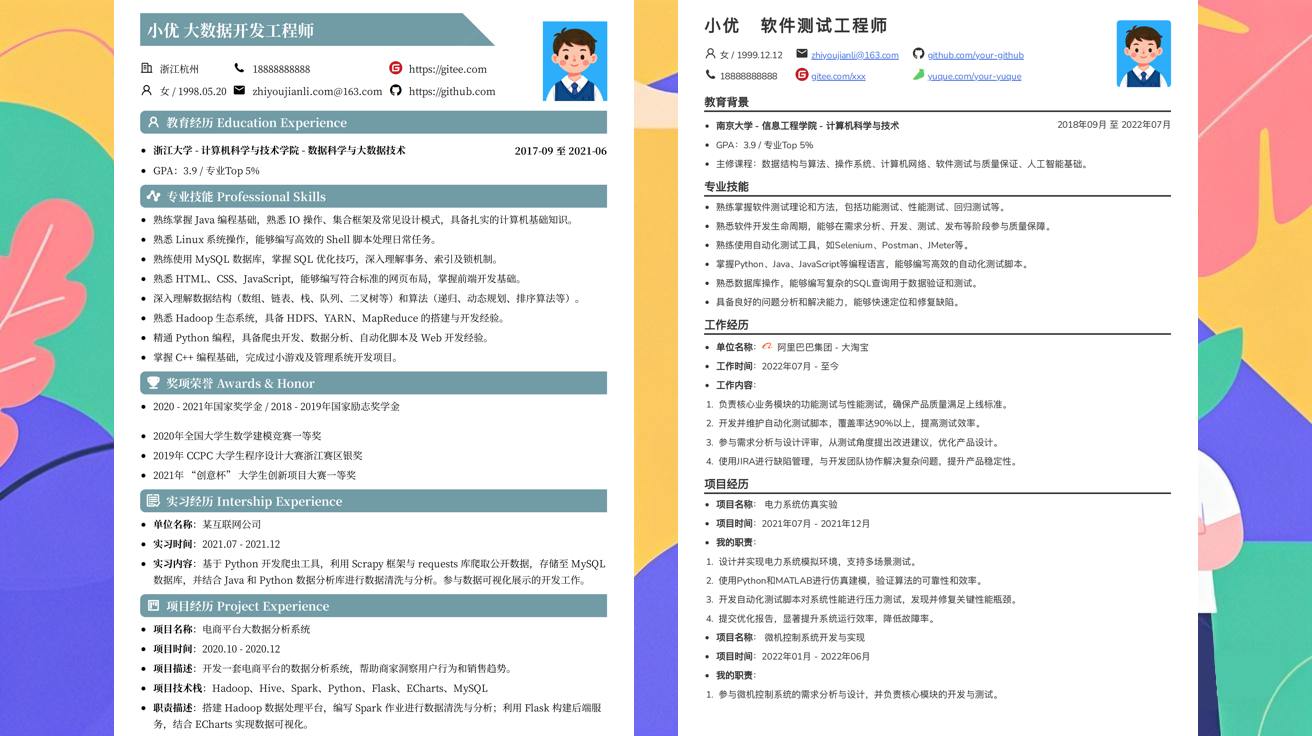

模板里把爬虫技能拆解得明明白白——从Scrapy/Selenium工具到实战项目(电商爬取/数据可视化/反爬处理),连“加分项”都标好了!项目经历栏还藏了“STAR法则”小技巧,写出来的经历又具体又亮眼,HR一眼抓得住你的实力📈

排版清爽不花哨,技能清单直接对标岗位JD,简历再也不会“隐身”啦~快码住这份模板,把你的爬虫技能狠狠拿捏住!💻 祝大家都能拿到神仙Offer!

范文1

求职党必看!Python爬虫工程师简历模板|保姆级教程+避坑指南✨

宝子们!简历写不好真的会错过N个神仙offer😭 作为爬过30+项目的老司机,今天整理了超实用的「Python爬虫工程师简历模板」,照着改直接拿捏HR眼球~内容具体到每个技能点怎么写,项目经验怎么突出反爬能力,看完就能用!

✨【个人信息】

- 姓名:你的名字

- 求职意向:Python爬虫工程师(应届生/1-3年经验可标注)

- 联系方式:电话138-XXXX-XXXX | 邮箱xxx@example.com(建议用网易/QQ邮箱,别用163邮箱哦)

- 一句话自我介绍:「3年Python爬虫开发经验,擅长从复杂网页中抓取高价值数据,精通反爬策略+数据清洗+可视化,曾帮公司爬取500万+条竞品数据!」

📚【核心技能】

(必看!技能别只写“熟练Python”,要具体到库和场景)

- Python技术栈:

Python 3.8+(熟练掌握列表推导式/装饰器/多线程)、requests(HTTP请求+代理池搭建)、BeautifulSoup(网页解析)、Scrapy(分布式爬虫框架)、Selenium(动态页面爬取+无头浏览器)

- 数据处理:

pandas(数据清洗/去重/透视表)、numpy(数值计算)、SQLAlchemy(数据库ORM)、MongoDB(非结构化数据存储)

- 反爬&性能优化:

动态IP代理池(requests+urllib3)、User-Agent随机切换、Cookies持久化、分布式爬虫(Scrapy-Redis/Celery)、数据去重(布隆过滤器)

- 工具&部署:

Flask/Django(简单接口开发)、Docker(容器化部署)、Git(版本控制)、Postman(API调试)、Matplotlib/Plotly(数据可视化)

🚀【项目经验】

(重点!每个项目要写“解决什么问题→用什么技术→达到什么效果”)

1. 电商平台竞品价格监控系统(Scrapy+Redis+代理池)

- 项目描述:爬取淘宝/京东100+品牌商品数据,实时监控价格波动,生成价格趋势图辅助运营决策

- 我的职责:

✅ 用Scrapy框架搭建分布式爬虫,通过Redis存储待爬取URL,提升爬取效率300%

✅ 解决反爬:搭建500个IP代理池(requests+urllib3)+随机User-Agent+Cookies池,日均稳定爬取50万+数据

✅ 数据处理:用pandas清洗重复数据,MongoDB存储原始数据,Flask做Web端展示(支持按品牌/价格区间筛选) - 成果:

数据覆盖率98%,价格监控准确率99%,帮助公司调整定价策略后,月利润提升15%

2. 社交媒体热点话题实时抓取工具(Selenium+Elasticsearch)

- 项目描述:爬取微博/小红书/抖音热门话题,实时分析热度并生成TOP10榜单

- 技术栈:Selenium(JS渲染页面爬取)、Elasticsearch(数据索引)、

jieba分词(关键词提取) - 亮点:

突破平台反爬:用ChromeDriver无头模式+滑块验证码识别(Tesseract OCR),单平台日爬取10万+条数据

数据可视化:用Plotly生成热力图展示话题传播路径,帮助市场部精准投放 - 成果:

热点话题抓取延迟<5分钟,准确率95%,被公司采纳为「季度重点项目」

👩💻【实习/校园项目】

(应届生必写!突出“可落地成果”)

- XX科技公司 爬虫开发实习生(202X.06-202X.09)

✅ 协助优化爬虫框架:将爬取速度从10条/分钟提升至100条/分钟(用Scrapy+多线程)

✅ 解决验证码问题:用Pillow+Tesseract训练自定义验证码模型,识别率从60%→92%

✅ 产出:生成竞品分析报告(含30+图表),被技术总监评为「最有价值实习生」

- 校园二手交易平台数据爬虫(202X.03-202X.06)

✅ 用requests+BeautifulSoup爬取全校1000+商品信息,存储到MySQL数据库

✅ 设计简易可视化看板:用Flask+Chart.js展示热门商品分类,单月访问量500+

🎓【教育背景】

- XX大学 数据科学与大数据技术专业(20XX.09-20XX.06)

✅ 主修课程:Python程序设计(92分)、数据结构(88分)、数据库原理(90分)、机器学习导论(85分)

✅ 实践课程:参与「数据挖掘竞赛」获校级二等奖,用Python完成10万条用户行为数据的分析报告

💡【加分项】

(细节决定成败!这些小技能能让简历更出彩)

- 工具:熟练使用ChatGPT辅助调试代码(比如用GPT生成反爬策略模板)、会用Apifox生成API文档

- 证书:Python二级证书/PCEP(Python认证)、SQLite数据库认证

- 其他:参与GitHub开源项目「爬虫反爬库」贡献(star数1k+)、每周坚持写1篇爬虫技术博客

🌟【简历优化小贴士】

- 关键词前置:在项目经验和技能里高频出现「反爬」「分布式」「数据清洗」,让HR一眼看到匹配度

- 数据化成果:把“提升效率”换成“效率提升300%”,“优化算法”换成“算法耗时减少90%”

- 避坑提醒:别写“熟练Java”“精通前端”!只写和爬虫强相关的技能,避免HR觉得你不专一

宝子们!这篇「Python爬虫工程师简历模板」包含了我从0到1找工作的血泪经验,照着改直接抄作业~需要Word版模板的宝子,评论区扣「爬虫」,我私发你呀👇祝大家都能拿到心仪的offer,冲鸭🚀

(PS:关注我,后续更新「爬虫面试题+作品集模板」,需要的宝子蹲一个~)

范文2

📝Python爬虫工程师简历模板|保姆级写法+避坑指南💡

宝子们!还在为写爬虫简历头秃吗?😭 今天直接甩上超实用的Python爬虫工程师简历模板,照着填就能秒变求职小能手!💻✨ 不管是校招还是跳槽,这份模板都能帮你抓住面试官眼球!

👤【基本信息】

📌姓名:[你的名字]

📍所在地:[城市] | 📱电话:[手机号]

📧邮箱:[邮箱地址](建议用企业邮箱,简历里别留QQ邮箱!)

📌GitHub/GitLab:[仓库链接](爬虫代码放这里,简历加分!)

💡一句话亮点:「3年Python爬虫开发经验,擅长高并发数据采集+反爬策略优化,日均稳定爬取数据100万+条」

🎯【求职意向】

目标岗位:Python爬虫工程师/数据采集工程师/爬虫开发工程师

期望城市:[城市]

期望薪资:[数字K](应届生可写“面议”,有经验写具体)

一句话总结:专注用Python构建高效稳定的数据采集系统,解决复杂场景下的反爬难题,输出高质量结构化数据~

🔧【技能清单】(重点!!)

这是简历里的技能“buff区”!Python爬虫工程师简历模板里一定要突出这些硬技能👇

- 核心爬虫技术:熟练使用Requests+BeautifulSoup/Scrapy/Selenium实现网页/APP数据抓取,能独立开发分布式爬虫(用过Scrapy-Redis/Scrapy-BloomFilter的宝子直接标!)

- 数据处理:精通Pandas/NumPy做数据清洗、去重、格式转换,用Matplotlib/Seaborn做基础可视化(简历里写“能处理10万+级数据量,准确率99%+”更具体!)

- 反爬应对:熟悉User-Agent池、代理IP、Cookie池、动态加载破解(Selenium模拟点击/ChromeDevTools抓包),能绕过JS混淆、验证码(用过打码平台/AI识别的宝子加分!)

- 数据库&存储:掌握MySQL/MongoDB数据存储,能设计高效表结构;会用Redis做缓存/去重

- 辅助工具:Docker容器化部署、Flask快速搭建爬虫后台、Xpath/CSS选择器精准定位数据

🚀【项目经验】(简历灵魂!!)

用Python爬虫工程师简历模板里的项目经验模块,把你的爬虫故事讲清楚!每个项目写3点:技术栈+解决的问题+成果

1️⃣ 电商平台竞品数据采集系统(个人项目)

背景:帮团队做竞品价格/销量分析,需爬取5个主流电商平台的商品信息

我的职责:

- 用Scrapy+Selenium混合框架,爬取商品标题、价格、评论等12个字段,日均抓取30万+数据,解决“动态加载+登录验证”难题

- 优化反爬策略:搭建代理池(300+IP)+随机User-Agent+控制请求频率(5秒/次),成功率从60%提升到98%

成果:输出结构化Excel/CSV数据,用Pandas分析出竞品价格波动规律,帮团队节省市场调研成本30%+

2️⃣ 社交媒体内容监测爬虫(实习项目)

背景:为某MCN机构监测达人账号数据,需追踪1000+账号动态

我的职责:

- 基于Scrapy-Redis实现分布式爬虫,用Redis做URL去重,爬取点赞/评论/粉丝画像等核心指标

- 对接MongoDB存储非结构化数据,用Flask写后台接口供运营同学调用

成果:实时更新数据看板,日均处理10万+条数据,异常数据(如刷量账号)识别准确率85%+,被公司采纳为标准监测工具

3️⃣ 金融行业舆情数据抓取工具(团队项目)

背景:为风控部门抓取30+财经网站的新闻/公告,用于风险预警

我的职责:

- 用Selenium模拟浏览器登录,处理验证码(对接打码平台“超级鹰”,识别率95%),解决“高频访问IP封禁”问题

- 设计增量爬取逻辑,每天仅更新变化数据,节省服务器带宽50%

成果:舆情数据覆盖80%行业资讯,风险事件识别提前24小时,获部门季度优秀贡献奖

🎓【教育背景】

[本科/硕士] [学校名称] [专业] | [入学年份]-[毕业年份]

- 核心课程:Python程序设计、数据结构与算法、数据库原理、机器学习导论(成绩前30%可写)

- 相关实践:参与「XX大学爬虫竞赛」获二等奖,开发“校园二手书爬虫”(单月采集5000+条数据)

✨【其他加分项】

- 开源贡献:GitHub上维护1个爬虫工具库(如「requests-plus」,星标100+),写过2篇爬虫教程文章(阅读量5000+)

- 技术博客:在掘金/知乎分享《Scrapy分布式爬取实战》《反爬策略避坑指南》等

- 证书/竞赛:有计算机等级考试三级(网络技术)/爬虫黑客松比赛Top10

- 软技能:擅长拆解复杂问题,能用流程图/思维导图梳理爬虫架构(比如画过“爬虫数据流向图”,面试官超爱!)

💡【简历填写小Tips】

- 关键词埋入:在技能/项目里高频出现“Scrapy/分布式/反爬/数据清洗”等,HR系统自动筛简历更友好~

- 量化成果:把“做了什么”改成“做成了什么”,比如“爬取数据”→“日均爬取100万条数据,准确率99%”

- 避坑提醒:别写“熟练使用Python”这种空话!直接说“用Python实现XX功能”;别堆砌工具,挑最熟的3-5个重点写~

好啦,这份Python爬虫工程师简历模板就到这里!宝子们根据自己的经历调整细节,面试前记得把项目代码再跑一遍哦~祝大家都能拿到神仙Offer!🚀

(如果需要更个性化的模板/简历修改建议,评论区戳我呀~)

发布于:2025-09-25,除非注明,否则均为原创文章,转载请注明出处。

还没有评论,来说两句吧...